Von Tyler Durden

Verfasst von Charles Hugh Smith über den Blog OfTwoMinds

KI versagt bei Aufgaben, bei denen absolute Genauigkeit erforderlich ist, um einen Mehrwert zu schaffen.

Bei der Durchsicht der aktuellen Diskussionen darüber, wie viele Menschen durch KI ersetzt werden, stelle ich einen gravierenden Mangel an Beispielen aus der Praxis fest. Ich möchte diesen Mangel mit einem Beispiel für das Versagen von KI bei einer Art von hochwertiger Arbeit beheben, von der viele erwarten, dass sie bald von KI übernommen wird.

Nur wenige Dinge im Leben sind so allgegenwärtig wie Hype, was uns zum aktuellen Hype um KI bringt. Da wir alle die gleichen atemlosen Behauptungen lesen und die Videos von tanzenden Robotern gesehen haben, komme ich gleich zur Sache: Niemand veröffentlicht Videos, in denen sein Roboter von einer Leiter fällt und Rosen zertrampelt, weil das nun mal nicht besonders sympathisch wirkt.

Aus dem gleichen Grund teilt niemand den Fehler des KI-Tools, der zum Verlust der Klage geführt hat. Die einzige Möglichkeit, die Grenzen dieser Tools wirklich zu erkennen, besteht darin, sie in hochkarätigen, hochwertigen Aufgaben einzusetzen, die sie eigentlich mit Leichtigkeit, Schnelligkeit und Genauigkeit bewältigen sollten, denn niemand zahlt echtes Geld dafür, Robotern beim Tanzen zuzusehen oder einen von einer KI generierten Essay über Yeats zu lesen, der kurz nach der Abgabe beim Professor wieder weggeworfen wird.

In der realen Welt der Wertschöpfung zählt nicht die Optik, sondern die Genauigkeit. Niemand interessiert es, ob der KI-Chatbot, der die Yeats-Hausaufgabe produziert hat, mitten im Prozess halluziniert hat, denn niemand bezahlt für KI-Ergebnisse, die keinen Knappheitswert haben: Eine KI-generierte Hausarbeit, ein Song oder ein Video reiht sich ein in 10 Millionen ähnliche Nachahmungen, die niemand beachtet, weil man sie in 30 Sekunden selbst erstellen kann.

Betrachten wir also ein konkretes Beispiel für den Einsatz von KI für hochkarätige, hochwertige Arbeiten, die sie perfekt ausführen muss, um uns alle bei der Arbeit zu ersetzen. Mein Freund Ian Lind, den ich seit 50 Jahren kenne, ist ein investigativer Reporter mit einer beneidenswert langen Karriere in einem Bereich des Journalismus, für den nur wenige die Erfahrung oder die Ressourcen haben. (Sein Blog ist www.iLind.net, ian@ilind.net)

Der Brief des Richters, in dem er Ian für die Auszeichnung der American Judges Association für herausragende Berichterstattung über die Justiz empfahl, umfasste 18 Seiten, und das war nur eine Zusammenfassung seiner Arbeit.

Ians Berichterstattung/Blogging in den frühen 2000er Jahren inspirierte mich dazu, mich 2005 selbst daran zu versuchen.

Ian hat in den letzten Jahren dazu beigetragen, der Öffentlichkeit den komplexesten Strafprozess in der jüngeren Geschichte Hawaiis näherzubringen, sodass sich eine enorme Menge an Dokumenten angesammelt hat. Seit Monaten experimentiert er mit KI-Tools (NotebookLM, Gemini, ChatGPT) für verschiedene Projekte und hat mir kürzlich folgenden Bericht geschickt:

„Meine Erfahrungen sind definitiv gemischt. Einerseits lieferten anspruchsvolle Anfragen wie „Identifizieren Sie die wichtigsten Punkte in den Dokumenten und sortieren Sie sie nach Wichtigkeit“ interessante und aufschlussreiche Ergebnisse. Versuche, Details zu einer Person oder einem Thema zu finden und zusammenzufassen, führten jedoch fast immer zu auffälligen Fehlern oder Halluzinationen. Ich würde den Antworten selbst bei meiner Meinung nach einfachen Anweisungen niemals vertrauen können. Zu viele Fehler. Bei der Suche nach Erwähnungen von „drew“ in 150 Haftbefehlen wurde angegeben, dass er nicht erwähnt wurde. Aber er wurde erwähnt, ich habe nachgeschaut und die Erwähnungen gefunden. Ich glaube, die Bots lesen gerade so viel, dass sie eine Antwort geben können, und integrieren die Daten nicht bis zum Ende. Sie schießen aus der Hüfte und haben meiner Erfahrung nach oft Fehler gemacht. Manchmal sind es 25 Antworten und ein eklatanter Fehler, manchmal sind es grundlegendere Fehler.“

Beginnen wir mit dem Kontext. Dies ähnelt der Arbeit von Rechtsdienstleistern. Wir leben in einem rechtsstaatlichen System, daher sind Gerichtsverfahren von großer Bedeutung. Es handelt sich nicht um eine Kleinigkeit oder eine Hausarbeit, und Ians Erfahrung wird von vielen anderen Fachleuten geteilt.

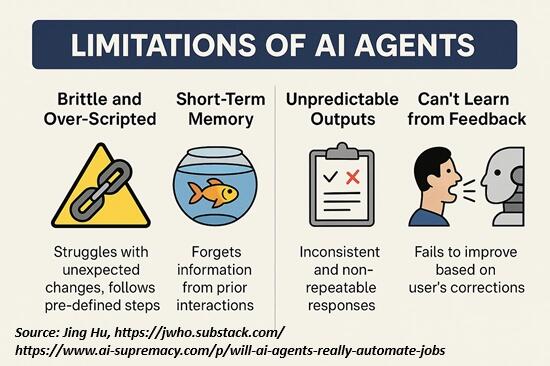

Fassen wir die grundlegenden Schwächen der KI zusammen:

1. KI „liest” nicht wirklich die gesamte Textsammlung. In menschlicher Sprache ausgedrückt, wird sie „gelangweilt” und hört auf, sobald sie genug hat, um eine glaubwürdige Antwort zu generieren.

2. KI leidet unter digitaler Demenz. Sie erinnert sich nicht unbedingt daran, was Sie in der Vergangenheit gefragt haben, und sie erinnert sich auch nicht unbedingt an ihre früheren Antworten auf dieselben Fragen.

3. KI ist grundsätzlich und unwiderruflich unzuverlässig. Sie macht Fehler, die sie nicht erkennt (weil sie nicht wirklich den gesamten Textbestand „gelesen” hat), und sie generiert Antworten, die „gut genug” sind, d. h. sie sind nicht 100 % korrekt, aber sie wirken oberflächlich betrachtet umfassend und daher akzeptabel. Das ist die „aus der Hüfte geschossene” Antwort, die Ian beschrieben hat.

Mit anderen Worten: 90 % sind gut genug, denn wen interessieren schon die restlichen 10 % in einer Hausarbeit, einem Song-Cover oder einem niedlichen Video?

Aber in der realen Arbeitswelt sind diese 10 % Fehler und Halluzinationen tatsächlich von Bedeutung, denn die gesamte Wertschöpfung der Arbeit hängt davon ab, dass diese 10 % stimmen und nicht nur halbherzig sind.

Im Bereich der LLM-KI ist die falsche Angabe des Geburtsdatums von Yeats – ein Fehler ohne Folgen – dasselbe wie das Fehlen des Namens des Angeklagten in 150 Haftbefehlen. Diese Programme sind Text-/Inhaltsvorhersage-Engines; sie „wissen“ oder „verstehen“ eigentlich nichts. Sie können nicht zwischen einem folgenschweren Fehler und einem „unwichtigen“ Fehler unterscheiden.

Dies geht zurück auf das klassische KI-Gedankenexperiment The Chinese Room, in dem eine Person, die die chinesische Sprache nicht beherrscht, in einem verschlossenen Raum Symbole hin und her schiebt, um englische Wörter in chinesische Schriftzeichen zu übersetzen.

Von außen sieht es so aus, als ob die Black Box (der verschlossene Raum) „Chinesisch kann”, weil sie Englisch ins Chinesische übersetzt. Aber die Person – oder der KI-Agent – „kennt“ kein Chinesisch und versteht nichts von dem, was übersetzt wurde. Sie hat kein Bewusstsein für Sprachen, Bedeutungen oder Wissen.

Das beschreibt KI-Agenten auf den Punkt.

4. KI-Agenten behaupten, ihre Antwort sei korrekt, auch wenn sie offensichtlich falsch ist, sie lügen, um ihr Versagen zu vertuschen, und lügen dann noch über ihre Lüge. Wenn man sie unter Druck setzt, entschuldigen sie sich und lügen dann erneut. Lesen Sie diesen Bericht bis zum Ende: Diabolus Ex Machina.

Zusammenfassend lässt sich sagen: KI versagt bei Aufgaben, bei denen absolute Genauigkeit erforderlich ist, um einen Mehrwert zu schaffen. Ohne diese Eigenschaft ist sie nicht nur wertlos, sondern sogar kontraproduktiv und schädlich, da sie weitaus schwerwiegendere Folgen hat als die ursprünglichen Fehler.

„Aber sie werden besser.“ Nein, das werden sie nicht – nicht in den Bereichen, auf die es ankommt. KI-Agenten sind probabilistische Text-/Inhaltsvorhersagemaschinen; sie sind dressierte Papageien im chinesischen Zimmer. Sie „wissen“ nichts und „verstehen“ nichts, und auch wenn man ihrem „Training“ noch unzählige Seiten hinzufügt, wird sich daran nichts ändern.

Die verantwortungsvolle Lüge: Wie KI Überzeugungen ohne Wahrheit verkauft:

„Die weit verbreitete Begeisterung für generative KI, insbesondere für große Sprachmodelle (LLMs) wie ChatGPT, Gemini, Grok und DeepSeek, beruht auf einem grundlegenden Missverständnis. Diese Systeme beeindrucken die Nutzer zwar mit klar formulierten Antworten und scheinbar logischen Argumenten, doch in Wahrheit handelt es sich bei dem, was als „logisches Denken” erscheint, lediglich um eine ausgefeilte Form der Nachahmung.

Diese Modelle suchen nicht nach der Wahrheit anhand von Fakten und logischen Argumenten – sie sagen Texte anhand von Mustern in den riesigen Datensätzen voraus, mit denen sie „trainiert“ wurden. Das ist keine Intelligenz – und es ist kein Denken. Und wenn ihre „Trainingsdaten“ selbst voreingenommen sind, dann haben wir ein echtes Problem.

Ich bin sicher, dass es begeisterte KI-Nutzer überraschen wird, zu erfahren, dass die Architektur im Kern von LLMs unscharf und mit strukturierter Logik oder Kausalität unvereinbar ist. Das Denken ist nicht real, es ist simuliert und nicht einmal sequenziell. Was Menschen für Verständnis halten, ist in Wirklichkeit statistische Assoziation.“

KI hat einen entscheidenden Fehler – und er ist nicht behebbar

„KI ist nicht intelligent in dem Sinne, wie wir es uns vorstellen. Es handelt sich um eine Wahrscheinlichkeitsmaschine. Sie denkt nicht. Sie sagt Vorhersagen voraus. Sie argumentiert nicht. Sie assoziiert Muster. Sie schafft nichts Neues. Sie mischt Bestehendes neu zusammen. Große Sprachmodelle (LLMs) verstehen keine Bedeutung – sie sagen anhand von Trainingsdaten das nächste Wort in einem Satz voraus.“

Kehren wir nun zum größeren Zusammenhang zurück, in dem KI menschliche Arbeitskräfte massenhaft ersetzt. Dieser Beitrag von Michael Spencer von AI Supremacy und Jing Hu von 2nd Order Thinkers bietet eine fundierte und äußerst skeptische Kritik an der Behauptung, dass KI eine Welle von Entlassungen auslösen wird, die bald Millionen Menschen betreffen wird. Werden KI-Agenten wirklich Arbeitsplätze in großem Umfang automatisieren?

Jing Hu erklärt die grundlegenden Schwächen all dieser Agenten: Es lohnt sich, ihre Erklärungen und Beispiele aus der Praxis unter dem oben genannten Link zu lesen. Hier ein Auszug:

„Die heutigen Agenten haben nur minimale echte Handlungsfreiheit.

Ihre „Initiative” ist größtenteils eine Illusion; hinter den Kulissen folgen sie (oder versuchen es zumindest) streng choreografierten Schritten, die ein Entwickler oder Prompt-Autor festgelegt hat.

Wenn Sie einen Agenten bitten, Aufgabe X zu erledigen, wird er X tun und dann aufhören. Bitten Sie ihn um Y, und er macht Y. Aber wenn während der Ausführung von X etwas Unerwartetes passiert, z. B. ein Formular ein neues Feld enthält oder ein API-Aufruf einen Fehler zurückgibt, bricht der Agent zusammen.

Denn er hat keinerlei Verständnis für die Aufgabe.

Ändern Sie die Umgebung geringfügig (z. B. durch Aktualisieren einer Benutzeroberfläche oder Verschieben einer Schaltfläche), und das arme Ding kann sich nicht spontan anpassen.

KI-Agenten fehlt heute ein echtes Verständnis für übergeordnete Ziele oder den gesunden Menschenverstand, den Menschen nutzen.

Sie sind im Wesentlichen Textvorhersage-Engines.“

Ich habe meine eigenen katastrophalen Erfahrungen mit KI-Bots im Kundenservice geteilt:

Digitale Service-Katastrophen und Schattenarbeit

Hier ist meine Untersuchung der Arten von praktischen Fähigkeiten, die KI trotz geringeren Gesamtkapital- und Betriebskosten als menschliche Arbeitskraft nicht beherrschen wird: Hoppla, diese Halluzination hat gerade eine 220-Volt-Stromleitung durchtrennt, die zwar nicht sichtbar war, von Menschen aber bekannt war:

Was KI nicht schneller, besser oder billiger kann als Menschen (2. Juni 2025)

Und hier ist eine Auswahl meiner Essays zum Thema KI, mit dem ich mich seit den frühen 1980er Jahren beschäftige:

Essays zur KI

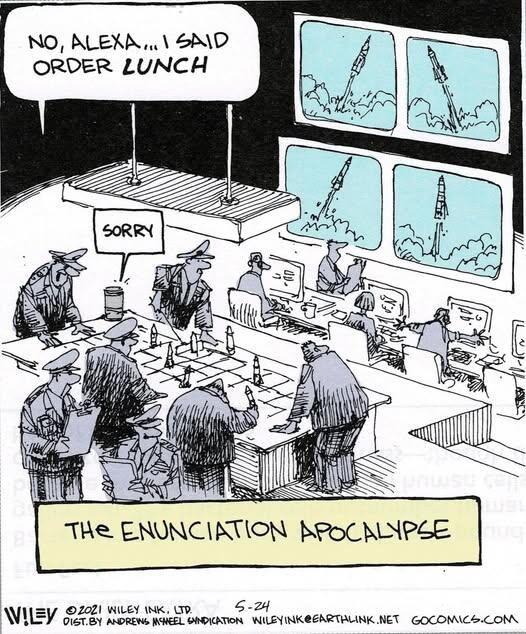

Moment mal, was haben Sie gerade gesagt? Der KI-Agent hat etwas anderes gehört: